Le immagini generate dall’intelligenza artificiale mettono in pericolo la scienza: ecco come i ricercatori vogliono riconoscerle

I ricercatori stanno lottando contro le immagini false generate dall’intelligenza artificiale nelle pubblicazioni scientifiche. Si stanno sviluppando nuovi metodi di rilevamento.

Le immagini generate dall’intelligenza artificiale mettono in pericolo la scienza: ecco come i ricercatori vogliono riconoscerle

Scienziati che manipolano numeri e producono in serie documenti falsi Editori obbligatori – i manoscritti problematici sono da tempo un fastidio nella letteratura scientifica. Gli investigatori scientifici lavorano instancabilmente, per denunciare questo illecito e correggere la documentazione scientifica. Ma il loro lavoro sta diventando sempre più difficile poiché è emerso un nuovo, potente strumento per i truffatori: quello generativo intelligenza artificiale (AI).

“L’intelligenza artificiale generativa si sta sviluppando molto rapidamente”, afferma Jana Cristoforo, Analista di integrità dell'immagine presso FEBS Press a Heidelberg, Germania. “Le persone che lavorano nel mio settore – integrità dell’immagine e politiche editoriali – sono sempre più preoccupate per le possibilità che ciò offre”.

La facilità con cui testi di strumenti di intelligenza artificiale generativa, immagini e dati fanno temere una letteratura scientifica sempre più inaffidabile, inondata di numeri falsi, manoscritti e conclusioni difficili da rilevare per gli esseri umani. Una corsa agli armamenti sta già emergendo per la quale specialisti dell’integrità, editori e aziende tecnologiche lavorano diligentemente Sviluppare strumenti di intelligenza artificiale, che può aiutare a identificare rapidamente elementi ingannevoli generati dall'intelligenza artificiale negli articoli specialistici.

“È uno sviluppo spaventoso”, afferma Christopher. “Ma ci sono anche persone intelligenti e buoni cambiamenti strutturali proposti”.

Gli esperti di integrità della ricerca riferiscono che, sebbene il testo generato dall’intelligenza artificiale sia già consentito in determinate circostanze da molte riviste, l’utilizzo di tali strumenti per creare immagini o altri dati potrebbe essere considerato meno accettabile. "Nel prossimo futuro, potremmo essere d'accordo con il testo generato dall'intelligenza artificiale", afferma Elisabetta Bik, specialista in immagine forense e consulente a San Francisco, California. "Ma traccio un limite quando si tratta di generare dati."

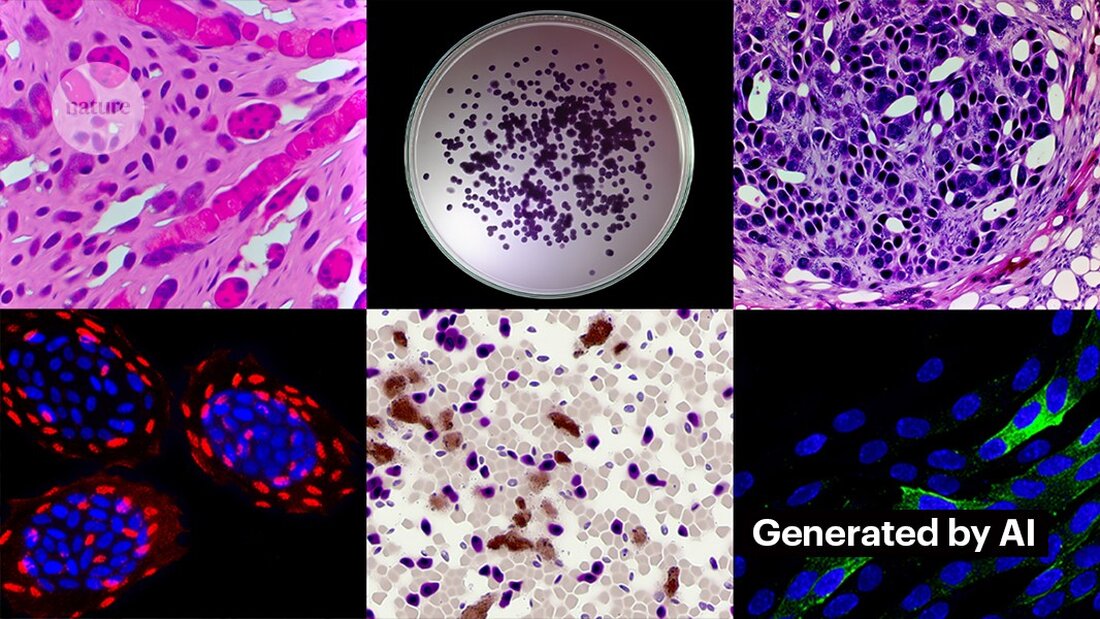

Bik, Christopher e altri suggeriscono che i dati, comprese le immagini, creati con l’intelligenza artificiale generativa sono già ampiamente utilizzati in letteratura e che gli editori obbligatori stanno utilizzando strumenti di intelligenza artificiale per produrre manoscritti in volume (vedi “Quiz: puoi individuare i falsificazioni dell’intelligenza artificiale?”).

Identificare le immagini prodotte dall’intelligenza artificiale rappresenta una sfida enorme: spesso è quasi impossibile distinguerle dalle immagini reali a occhio nudo. "Abbiamo la sensazione di imbatterci ogni giorno in immagini generate dall'intelligenza artificiale", afferma Christopher. "Ma a meno che tu non possa dimostrarlo, c'è davvero molto poco che puoi fare."

Ci sono alcuni chiari esempi dell’uso dell’intelligenza artificiale generativa nelle immagini scientifiche, come immagine ormai famigerata di un topo con genitali assurdamente grandi ed etichette senza senso, create con lo strumento immagine Midjourney. La grafica, pubblicata da una rivista di settore a febbraio, ha suscitato scalpore sui social e così è stato ritirato qualche giorno dopo.

Tuttavia, la maggior parte dei casi non sono così evidenti. Le figure create utilizzando Adobe Photoshop o strumenti simili prima dell'avvento dell'intelligenza artificiale generativa, in particolare nella biologia molecolare e cellulare, spesso contengono caratteristiche sorprendenti che possono essere riconosciute dagli investigatori, come sfondi identici o l'insolita mancanza di strisce o macchie. I personaggi generati dall'IA spesso non mostrano tali caratteristiche. "Vedo molti documenti che mi fanno pensare che questi Western blot non sembrino reali, ma non esiste una pistola fumante", dice Bik. "Tutto quello che puoi dire è che sembrano strani, e ovviamente non è una prova sufficiente per contattare l'editore."

Tuttavia, ci sono segnali che i personaggi generati dall’intelligenza artificiale compaiono nei manoscritti pubblicati. I testi scritti utilizzando strumenti come ChatGPT stanno aumentando negli articoli, evidenti nelle frasi tipiche dei chatbot che gli autori dimenticano di rimuovere e nelle parole distintive che i modelli di intelligenza artificiale tendono a utilizzare. "Dobbiamo quindi supporre che ciò accada anche per dati e immagini", afferma Bik.

Un'altra indicazione che i truffatori utilizzano sofisticati strumenti di imaging è che la maggior parte dei problemi che gli investigatori stanno attualmente riscontrando compaiono in lavori vecchi di diversi anni. "Negli ultimi anni abbiamo riscontrato sempre meno problemi con le immagini", afferma Bik. "Penso che la maggior parte delle persone sorprese a manipolare immagini abbiano iniziato a creare immagini più pulite."

Creare immagini pulite con l'intelligenza artificiale generativa non è difficile. Kevin Patrick, un detective dell'immagine scientifica conosciuto come Cheshire sui social media, ha dimostrato quanto possa essere facile e ha pubblicato le sue scoperte su X. Utilizzando lo strumento di intelligenza artificiale di Photoshop Generative Fill, Patrick ha creato immagini realistiche - che potrebbero apparire in articoli scientifici - di tumori, colture cellulari, Western blot e altro ancora. La creazione della maggior parte delle immagini ha richiesto meno di un minuto (vedi “Generazione di false scienze”).

“Se posso farlo, sicuramente lo faranno anche coloro che sono pagati per creare dati falsi”, afferma Patrick. "Probabilmente ci sono molti altri dati che potrebbero essere generati utilizzando strumenti come questo."

Alcuni editori riferiscono di aver trovato prove di contenuti generati dall’intelligenza artificiale negli studi pubblicati. Ciò include PLoS, che è stato avvisato di contenuti sospetti e ha trovato prove di testo e dati generati dall'intelligenza artificiale in articoli e contributi attraverso indagini interne, afferma Renée Hoch, redattore del team di etica delle pubblicazioni di PLoS a San Francisco, California. (Hoch osserva che l'uso dell'intelligenza artificiale non è vietato nelle riviste PLoS e che la politica sull'intelligenza artificiale si basa sulla responsabilità dell'autore e sulla divulgazione trasparente.)

Anche altri strumenti potrebbero offrire opportunità a chi desidera creare contenuti falsi. Il mese scorso i ricercatori hanno pubblicato a 1 modello di intelligenza artificiale generativa per creare immagini al microscopio ad alta risoluzione – e alcuni specialisti di integrità hanno espresso preoccupazioni su questo lavoro. "Questa tecnologia può essere facilmente utilizzata da persone con cattive intenzioni per creare rapidamente centinaia o migliaia di immagini false", afferma Bik.

Yoav Shechtman del Technion–Israel Institute of Technology di Haifa, il creatore dello strumento, afferma che lo strumento è utile per creare dati di addestramento per i modelli perché le immagini al microscopio ad alta risoluzione sono difficili da ottenere. Ma aggiunge che non è utile per generare falsi perché gli utenti hanno poco controllo sui risultati. I software esistenti di editing delle immagini come Photoshop sono più utili per manipolare le figure, suggerisce.

Anche se gli occhi umani potrebbero non essere in grado di farlo Riconoscere le immagini generate dall'intelligenza artificiale, l’intelligenza artificiale potrebbe farlo (vedi “Le immagini dell’intelligenza artificiale sono difficili da riconoscere”).

Gli sviluppatori di strumenti come Imagetwin e Proofig, che utilizzano l’intelligenza artificiale per rilevare problemi di integrità nelle immagini scientifiche, stanno espandendo il loro software per filtrare le immagini create dall’intelligenza artificiale generativa. Poiché tali immagini sono così difficili da riconoscere, entrambe le società stanno creando i propri database di immagini di intelligenza artificiale generativa per addestrare i propri algoritmi.

Proofig ha già rilasciato una funzionalità nel suo strumento per riconoscere le immagini del microscopio generate dall'intelligenza artificiale. Il co-fondatore Dror Kolodkin-Gal di Rehovot, Israele, afferma che nei test con migliaia di immagini reali e generate dall'intelligenza artificiale provenienti da articoli, l'algoritmo ha identificato correttamente le immagini AI il 98% delle volte e ha riscontrato un tasso di falsi positivi dello 0,02%. Dror aggiunge che il team sta ora cercando di capire cosa rileva esattamente il loro algoritmo.

"Ho grandi speranze per questi strumenti", afferma Christopher. Tuttavia, osserva che i loro risultati devono sempre essere valutati da esperti in grado di verificare i problemi che indicano. Christopher non ha ancora visto alcuna prova che il software di riconoscimento delle immagini AI sia affidabile (la valutazione interna di Proofig non è stata ancora pubblicata). Questi strumenti sono "limitati, ma sicuramente molto utili perché ci consentono di ampliare i nostri sforzi di revisione delle proposte", aggiunge.

Molti editori e istituti di ricerca lo stanno già utilizzando Prova E Immagine gemella. Ad esempio, le riviste scientifiche utilizzano Proofig per verificare i problemi di integrità nelle immagini. Secondo Meagan Phelan, direttore delle comunicazioni di Science a Washington DC, lo strumento non ha ancora scoperto alcuna immagine generata dall’intelligenza artificiale.

Springer Nature, l'editore di Nature, sta sviluppando i propri strumenti di rilevamento di testo e immagini, chiamati Geppetto e SnapShot, che segnalano le irregolarità che vengono poi valutate dagli esseri umani. (Il team di notizie di Nature è editorialmente indipendente dal suo editore.)

Anche i gruppi editoriali stanno adottando misure per rispondere alle immagini generate dall’intelligenza artificiale. Un portavoce dell'Associazione internazionale degli editori scientifici, tecnici e medici (STM) di Oxford, nel Regno Unito, ha affermato che sta prendendo la questione "molto sul serio" e che sta rispondendo a iniziative come United2Act e STM Integrity Hub, che affronta le questioni attuali relative alla pubblicazione obbligatoria e ad altre questioni di integrità accademica.

Christopher, che guida un gruppo di lavoro STM sulle alterazioni e duplicazioni delle immagini, afferma che esiste una crescente consapevolezza che sarà necessario sviluppare modi per verificare i dati grezzi, ad esempio etichettando le immagini scattate con i microscopi con filigrane invisibili simili a quelle utilizzate Filigrane nei testi generati dall'intelligenza artificiale – potrebbe essere la strada giusta. Ciò richiede nuove tecnologie e nuovi standard per i produttori di dispositivi, aggiunge.

Patrick e altri temono che gli editori non agiscano abbastanza rapidamente per affrontare la minaccia. "Temiamo che questa sarà solo un'altra generazione di problemi in letteratura che non verranno affrontati finché non sarà troppo tardi", dice.

Tuttavia, alcuni sono ottimisti sul fatto che i contenuti generati dall’intelligenza artificiale che compaiono oggi negli articoli verranno scoperti in futuro.

"Ho piena fiducia che la tecnologia migliorerà al punto da riconoscere i dati che vengono creati oggi, perché a un certo punto questi saranno considerati relativamente grossolani", afferma Patrick. "I truffatori non dovrebbero dormire bene la notte. Potrebbero ingannare il processo attuale, ma non credo che possano ingannarlo per sempre."

-

Saguy, A. et al. Piccola metanfetamine. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto