AI-genererte bilder setter vitenskapen i fare – det er slik forskere vil gjenkjenne dem

Forskere kjemper mot AI-genererte falske bilder i vitenskapelige publikasjoner. Nye metoder for deteksjon er under utvikling.

AI-genererte bilder setter vitenskapen i fare – det er slik forskere vil gjenkjenne dem

Forskere manipulerer tall og masseproduserer falske papirer Obligatoriske forlag – problematiske manuskripter har lenge vært en plage i vitenskapelig litteratur. Vitenskapelige detektiver jobber utrettelig, for å avsløre denne forseelsen og korrigere den vitenskapelige oversikten. Men jobben deres blir stadig vanskeligere ettersom et nytt, kraftig verktøy for svindlere har dukket opp: generativ kunstig intelligens (AI).

"Generativ AI utvikler seg veldig raskt," sier Jana Christopher, Image Integrity Analyst ved FEBS Press i Heidelberg, Tyskland. "Folk som jobber i mitt område - bildeintegritet og publiseringspolitikk - blir stadig mer bekymret for mulighetene det gir."

Den letthet som generative AI-verktøytekster, vekker bilder og data frykt for en stadig mer upålitelig vitenskapelig litteratur, oversvømmet med falske tall, manuskripter og konklusjoner som er vanskelige for mennesker å oppdage. Et våpenkappløp dukker allerede opp når integritetsspesialister, utgivere og teknologiselskaper jobber iherdig for å Utvikle AI-verktøy, som kan hjelpe raskt å identifisere villedende, AI-genererte elementer i spesialistartikler.

"Det er en skremmende utvikling," sier Christopher. "Men det er også smarte folk og gode strukturelle endringer som foreslås."

Forskningsintegritetseksperter rapporterer at selv om AI-generert tekst allerede er tillatt under visse omstendigheter av mange tidsskrifter, kan bruk av slike verktøy for å lage bilder eller andre data anses som mindre akseptabelt. "I nær fremtid kan det hende at vi har det bra med AI-generert tekst," sier Elisabeth Bik, bilderettsmedisinsk spesialist og konsulent i San Francisco, California. "Men jeg trekker grensen når det gjelder å generere data."

Bik, Christopher og andre antyder at data, inkludert bilder, laget med generativ AI allerede er mye brukt i litteraturen, og at obligatoriske utgivere bruker AI-verktøy for å produsere manuskripter i volum (se "Quiz: Kan du oppdage AI-forfalskninger?").

Å identifisere AI-produserte bilder utgjør en enorm utfordring: de er ofte nesten umulige å skille fra ekte bilder med det blotte øye. "Vi føler at vi kommer over AI-genererte bilder hver dag," sier Christopher. "Men med mindre du kan bevise det, er det veldig lite du kan gjøre."

Det er noen klare eksempler på bruk av generativ AI i vitenskapelige bilder, som nå beryktet bilde av en rotte med absurd store kjønnsorganer og useriøse etiketter, laget med bildeverktøyet Midjourney. Grafikken, publisert av et fagblad i februar, skapte storm på sosiale medier og ble det trukket tilbake noen dager senere.

Imidlertid er de fleste tilfeller ikke så åpenbare. Figurer laget med Adobe Photoshop eller lignende verktøy før fremkomsten av generativ AI – spesielt innen molekylær- og cellebiologi – inneholder ofte slående trekk som kan gjenkjennes av detektiver, for eksempel identiske bakgrunner eller den uvanlige mangelen på striper eller flekker. AI-genererte karakterer viser ofte ikke slike egenskaper. "Jeg ser mange papirer som får meg til å tro at disse Western blottene ikke ser ekte ut - men det er ingen pistol som ryker," sier Bik. "Alt du kan si er at de bare ser merkelige ut, og det er selvfølgelig ikke nok bevis til å kontakte redaktøren."

Imidlertid er det tegn på at AI-genererte karakterer vises i publiserte manuskripter. Tekster skrevet ved hjelp av verktøy som ChatGPT øker i artikler, tydelig av typiske chatbot-fraser som forfattere glemmer å fjerne og særegne ord som AI-modeller pleier å bruke. "Så vi må anta at dette også skjer for data og bilder," sier Bik.

En annen indikasjon på at svindlere bruker sofistikerte bildeverktøy, er at de fleste problemene etterforskerne for tiden finner dukker opp i flere år gamle verk. "De siste årene har vi sett færre og færre problemer med bilder," sier Bik. "Jeg tror de fleste som ble tatt for å manipulere bilder begynte å lage renere bilder."

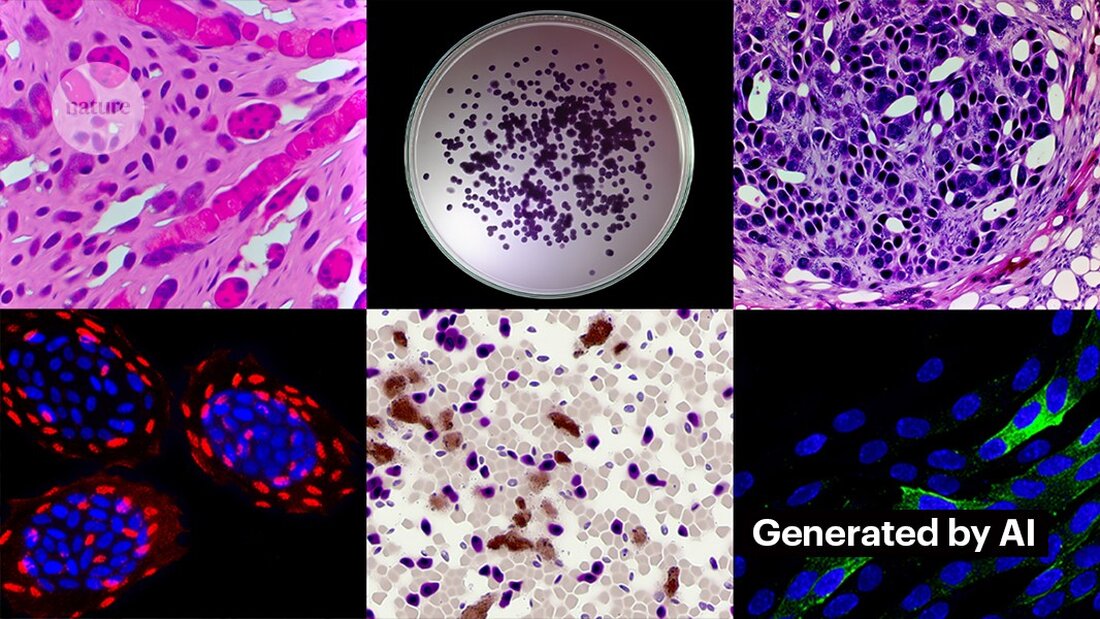

Å lage rene bilder med generativ AI er ikke vanskelig. Kevin Patrick, en vitenskapelig bildedetektiv kjent som Cheshire på sosiale medier, har demonstrert hvor enkelt det kan være og publisert funnene sine på X. Ved å bruke Photoshops AI-verktøy Generative Fill skapte Patrick realistiske bilder – som kan dukke opp i vitenskapelige artikler – av svulster, cellekulturer, Western blots og mer. De fleste bildene tok mindre enn ett minutt å lage (se «Generere falsk vitenskap»).

"Hvis jeg kan gjøre det, så vil de som blir betalt for å lage falske data også gjøre det," sier Patrick. "Det er sannsynligvis en hel masse andre data som kan genereres ved hjelp av verktøy som dette."

Noen utgivere rapporterer å finne bevis på AI-generert innhold i publiserte studier. Dette inkluderer PLoS, som har blitt varslet om mistenkelig innhold og funnet bevis på AI-generert tekst og data i artikler og innsendinger gjennom interne undersøkelser, sier Renée Hoch, redaktør for PLoS sitt publiseringsetiske team i San Francisco, California. (Hoch bemerker at bruk av AI ikke er forbudt i PLoS-tidsskrifter og at AI-policyen er basert på forfatteransvar og transparente avsløringer.)

Andre verktøy kan også gi muligheter for folk som ønsker å lage falskt innhold. Forrige måned publiserte forskere en 1 generativ AI-modell for å lage høyoppløselige mikroskopbilder – og noen integritetsspesialister uttrykte bekymring for dette arbeidet. "Denne teknologien kan enkelt brukes av folk med dårlige intensjoner for raskt å lage hundrevis eller tusenvis av falske bilder," sier Bik.

Yoav Shechtman ved Technion–Israel Institute of Technology i Haifa, verktøyets skaper, sier at verktøyet er nyttig for å lage treningsdata for modeller fordi høyoppløselige mikroskopbilder er vanskelige å få tak i. Men han legger til at det ikke er nyttig for å generere forfalskninger fordi brukerne har liten kontroll over resultatene. Eksisterende bilderedigeringsprogramvare som Photoshop er mer nyttig for å manipulere figurer, foreslår han.

Selv om menneskelige øyne kanskje ikke klarer det Gjenkjenne AI-genererte bilder, AI kan muligens gjøre dette (se 'AI-bilder er vanskelig å gjenkjenne').

Utviklerne av verktøy som Imagetwin og Proofig, som bruker AI for å oppdage integritetsproblemer i vitenskapelige bilder, utvider programvaren sin til å filtrere bilder laget av generativ AI. Fordi slike bilder er så vanskelige å gjenkjenne, lager begge selskapene sine egne databaser med generative AI-bilder for å trene algoritmene sine.

Proofig har allerede gitt ut en funksjon i sitt verktøy for å gjenkjenne AI-genererte mikroskopbilder. Medgründer Dror Kolodkin-Gal i Rehovot, Israel, sier at ved testing med tusenvis av AI-genererte og ekte bilder fra artikler, identifiserte algoritmen AI-bilder korrekt 98 % av tiden og hadde en falsk positiv rate på 0,02 %. Dror legger til at teamet nå prøver å forstå hva nøyaktig algoritmen deres oppdager.

"Jeg har store forhåpninger til disse verktøyene," sier Christopher. Hun påpeker imidlertid at resultatene deres alltid må evalueres av eksperter som kan verifisere problemene de indikerer. Christopher har ennå ikke sett noen bevis for at programvare for AI-bildegjenkjenning er pålitelig (Proofigs interne evaluering er ennå ikke publisert). Disse verktøyene er "begrensede, men absolutt svært nyttige for å tillate oss å skalere innsatsen for gjennomgang av innsendinger," legger hun til.

Mange forlag og forskningsinstitusjoner bruker det allerede Bevis og Bildetvilling. Science-tidsskrifter bruker for eksempel Proofig for å sjekke integritetsproblemer i bilder. Ifølge Meagan Phelan, kommunikasjonsdirektør for Science i Washington DC, har verktøyet ennå ikke oppdaget noen AI-genererte bilder.

Springer Nature, Natures utgiver, utvikler sine egne tekst- og bildegjenkjenningsverktøy, kalt Geppetto og SnapShot, som flagger uregelmessigheter som deretter blir evaluert av mennesker. (Nyhetsteamet Nature er redaksjonelt uavhengig av utgiveren.)

Publiseringsgrupper tar også skritt for å svare på AI-genererte bilder. En talsmann for International Association of Scientific, Technical and Medical (STM) Publishers i Oxford, Storbritannia, sa at de tar saken «svært alvorlig» og reagerer på initiativer som f.eks. United2Act og STM Integrity Hub, som tar opp aktuelle problemer med obligatorisk publisering og andre akademiske integritetsspørsmål.

Christopher, som leder en STM-arbeidsgruppe for bildeendringer og dupliseringer, sier det er en økende bevissthet om at det vil være nødvendig å utvikle måter å verifisere rådata på – for eksempel ved å merke bilder tatt med mikroskop med usynlige vannmerker som ligner på de som brukes Vannmerker i AI-genererte tekster – Det kan være den rette måten. Dette krever ny teknologi og nye standarder for enhetsprodusenter, legger hun til.

Patrick og andre bekymrer seg for at utgivere ikke handler raskt nok til å håndtere trusselen. "Vi frykter at dette bare vil være nok en generasjon av problemer i litteraturen som de ikke tar tak i før det er for sent," sier han.

Noen er likevel optimistiske om at det AI-genererte innholdet som vises i artikler i dag vil bli oppdaget i fremtiden.

"Jeg har full tillit til at teknologien vil forbedres til det punktet hvor den gjenkjenner dataene som blir opprettet i dag - for på et tidspunkt vil dette bli ansett som relativt grovt," sier Patrick. "Svindlere bør ikke sove godt om natten. De kan lure den nåværende prosessen, men jeg tror ikke de kan lure prosessen for alltid."

-

Saguy, A. et al. Liten Meth. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto