Obrázky generované AI ohrozujú vedu – takto ich chcú výskumníci rozpoznať

Výskumníci bojujú proti falošným obrázkom generovaným AI vo vedeckých publikáciách. Vyvíjajú sa nové metódy detekcie.

Obrázky generované AI ohrozujú vedu – takto ich chcú výskumníci rozpoznať

Vedci manipulujú s číslami a hromadne vyrábajú falošné papiere Povinní vydavatelia – problematické rukopisy boli vo vedeckej literatúre oddávna trápením. Vedeckí detektívi pracujú neúnavne, odhaliť toto previnenie a opraviť vedecký záznam. Ich práca je však čoraz ťažšia, pretože sa objavil nový, silný nástroj pre podvodníkov: generatívny umelá inteligencia (AI).

„Generatívna AI sa vyvíja veľmi rýchlo,“ hovorí Jana Krištofová, Image Integrity Analyst v FEBS Press v Heidelbergu, Nemecko. „Ľudia, ktorí pracujú v mojej oblasti – integrita imidžu a zásady publikovania – sa čoraz viac zaujímajú o možnosti, ktoré to ponúka.“

Ľahkosť, s akou texty generatívnych nástrojov AI, obrázky a údaje vyvolávajú obavy z čoraz nespoľahlivejšej vedeckej literatúry, ktorá je zaplavená falošnými číslami, rukopismi a závermi, ktoré je pre ľudí ťažké odhaliť. Už sa objavujú preteky v zbrojení, na ktorých špecialisti na integritu, vydavatelia a technologické spoločnosti usilovne pracujú Vyvíjajte nástroje AI, čo môže pomôcť rýchlo identifikovať klamlivé prvky generované AI v odborných článkoch.

„Je to desivý vývoj,“ hovorí Christopher. "Ale sú tu aj inteligentní ľudia a navrhujú sa dobré štrukturálne zmeny."

Odborníci na integritu výskumu uvádzajú, že hoci text generovaný AI je už za určitých okolností povolený mnohými časopismi, používanie takýchto nástrojov na vytváranie obrázkov alebo iných údajov sa môže považovať za menej prijateľné. „V blízkej budúcnosti môžeme byť v poriadku s textom generovaným AI,“ hovorí Elisabeth Bik, obrazový forenzný špecialista a konzultant v San Franciscu v Kalifornii. "Ale robím hranicu, pokiaľ ide o generovanie údajov."

Bik, Christopher a iní naznačujú, že údaje, vrátane obrázkov, vytvorené pomocou generatívnej AI sa už v literatúre bežne používajú a že povinní vydavatelia používajú nástroje AI na vytváranie objemných rukopisov (pozrite si „Kvíz: Dokážete rozpoznať falšovanie AI?“).

Identifikácia obrázkov vytvorených AI predstavuje obrovskú výzvu: často je takmer nemožné ich odlíšiť od skutočných obrázkov voľným okom. „Máme pocit, že s obrázkami vygenerovanými AI sa stretávame každý deň,“ hovorí Christopher. "Ale pokiaľ to nemôžete dokázať, môžete urobiť naozaj veľmi málo."

Existuje niekoľko jasných príkladov použitia generatívnej AI vo vedeckých obrázkoch, ako napr teraz neslávne známy obraz potkana s absurdne veľkými genitáliami a nezmyselné štítky, vytvorené pomocou obrazového nástroja Midjourney. Grafika, ktorú zverejnil odborný magazín vo februári, spôsobila búrku na sociálnych sieťach a bola stiahnuté o niekoľko dní neskôr.

Väčšina prípadov však nie je taká jednoznačná. Obrázky vytvorené pomocou programu Adobe Photoshop alebo podobných nástrojov pred príchodom generatívnej AI – najmä v molekulárnej a bunkovej biológii – často obsahujú výrazné črty, ktoré môžu detektívi rozpoznať, ako napríklad identické pozadie alebo nezvyčajný nedostatok pruhov či škvŕn. Postavy generované AI často nevykazujú takéto vlastnosti. "Vidím veľa papierov, ktoré ma nútia myslieť si, že tieto westernové škvrny nevyzerajú ako skutočné - ale nie je tam žiadna fajčiarska zbraň," hovorí Bik. "Môžete povedať len to, že vyzerajú čudne, a to samozrejme nestačí na to, aby ste kontaktovali redaktora."

Existujú však náznaky, že v publikovaných rukopisoch sa objavujú znaky generované AI. V článkoch pribúda textov napísaných pomocou nástrojov ako ChatGPT, čo je zrejmé z typických fráz chatbotov, ktoré autori zabúdajú odstrániť, a charakteristických slov, ktoré modely AI zvyknú používať. „Musíme teda predpokladať, že to platí aj pre údaje a obrázky,“ hovorí Bik.

Ďalším náznakom, že podvodníci používajú sofistikované zobrazovacie nástroje, je, že väčšina problémov, ktoré vyšetrovatelia v súčasnosti nachádzajú, sa objavuje v dielach, ktoré sú staré niekoľko rokov. „V posledných rokoch sme zaznamenali čoraz menej problémov s obrázkami,“ hovorí Bik. "Myslím si, že väčšina ľudí, ktorí boli prichytení pri manipulácii s obrázkami, začala vytvárať čistejšie obrázky."

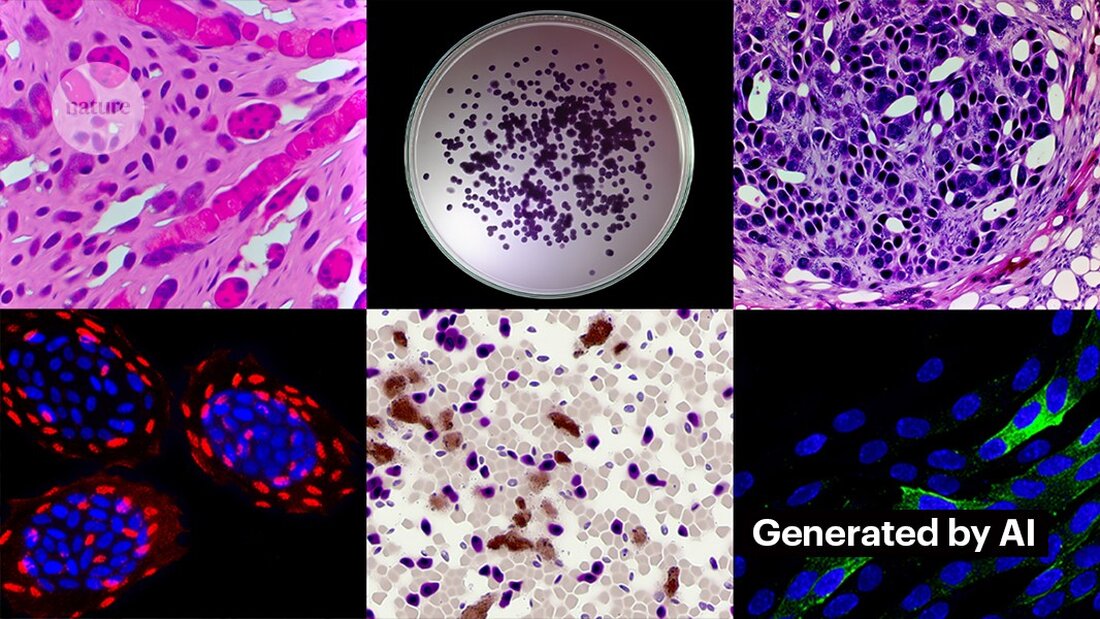

Vytváranie čistých obrázkov pomocou generatívnej AI nie je ťažké. Kevin Patrick, vedecký obrazový detektív známy ako Cheshire na sociálnych sieťach, ukázal, aké ľahké to môže byť, a svoje zistenia zverejnil na X. Pomocou nástroja AI vo Photoshope Generative Fill vytvoril Patrick realistické obrázky – ktoré by sa mohli objaviť vo vedeckých prácach – nádorov, bunkových kultúr, Western blotov a ďalších. Vytvorenie väčšiny obrázkov trvalo menej ako minútu (pozri „Generovanie falošnej vedy“).

„Ak to dokážem ja, určite to urobia aj tí, ktorí sú platení za vytváranie falošných údajov,“ hovorí Patrick. "Pravdepodobne existuje veľa ďalších údajov, ktoré by sa dali generovať pomocou nástrojov, ako je tento."

Niektorí vydavatelia uvádzajú, že v publikovaných štúdiách našli dôkazy o obsahu generovanom AI. To zahŕňa PLoS, ktorý bol upozornený na podozrivý obsah a našiel dôkazy o texte a údajoch generovaných AI v článkoch a príspevkoch prostredníctvom interného vyšetrovania, hovorí Renée Hoch, redaktorka tímu pre etiku publikácií PLoS v San Franciscu v Kalifornii. (Hoch poznamenáva, že používanie AI nie je zakázané v časopisoch PLoS a že politika AI je založená na zodpovednosti autorov a transparentných zverejneniach.)

Iné nástroje by tiež mohli poskytnúť príležitosti pre ľudí, ktorí chcú vytvárať falošný obsah. Minulý mesiac vedci publikovali a 1 generatívny model AI na vytváranie mikroskopických obrázkov s vysokým rozlíšením – a niektorí špecialisti na integritu vyjadrili obavy z tejto práce. „Túto technológiu môžu ľahko použiť ľudia so zlými úmyslami na rýchle vytvorenie stoviek alebo tisícok falošných obrázkov,“ hovorí Bik.

Yoav Shechtman z Technion-Israel Institute of Technology v Haife, tvorca nástroja, hovorí, že tento nástroj je užitočný na vytváranie tréningových údajov pre modely, pretože je ťažké získať mikroskopické snímky s vysokým rozlíšením. Dodáva však, že to nie je užitočné na generovanie falzifikátov, pretože používatelia majú malú kontrolu nad výsledkami. Existujúci softvér na úpravu obrázkov, ako je Photoshop, je užitočnejší na manipuláciu s postavami, navrhuje.

Aj keď to ľudské oči možno nezvládnu Rozpoznajte obrázky generované AI AI by to mohla urobiť (pozrite si „Obrázky AI je ťažké rozpoznať“).

Vývojári nástrojov ako Imagetwin a Proofig, ktoré používajú AI na zisťovanie problémov integrity vo vedeckých obrázkoch, rozširujú svoj softvér na filtrovanie obrázkov vytvorených generatívnou AI. Pretože je také ťažké rozpoznať takéto obrázky, obe spoločnosti vytvárajú svoje vlastné databázy generatívnych obrázkov AI na trénovanie svojich algoritmov.

Proofig už vydal funkciu vo svojom nástroji na rozpoznávanie mikroskopických obrázkov generovaných AI. Spoluzakladateľ Dror Kolodkin-Gal v Rehovote v Izraeli hovorí, že pri testovaní s tisíckami AI vytvorených a skutočných obrázkov z článkov algoritmus správne identifikoval obrázky AI v 98 % prípadov a mal falošnú pozitivitu 0,02 %. Dror dodáva, že tím sa teraz snaží pochopiť, čo presne ich algoritmus deteguje.

„Do týchto nástrojov vkladám veľké nádeje,“ hovorí Christopher. Poznamenáva však, že ich výsledky musia vždy vyhodnotiť odborníci, ktorí vedia overiť problémy, ktoré naznačujú. Christopher zatiaľ nevidel žiadne dôkazy, že softvér na rozpoznávanie obrazu AI je spoľahlivý (interné hodnotenie spoločnosti Proofig ešte nebolo zverejnené). Tieto nástroje sú „obmedzené, ale určite veľmi užitočné na to, aby nám umožnili zväčšiť naše úsilie o kontrolu podaní,“ dodáva.

Mnohé vydavateľstvá a výskumné inštitúcie ho už využívajú Dôkaz a Imagetwin. Napríklad vedecké časopisy používajú Proofig na kontrolu problémov s integritou v obrázkoch. Podľa Meagan Phelan, riaditeľky komunikácie pre vedu vo Washingtone DC, tento nástroj zatiaľ neobjavil žiadne obrázky generované AI.

Springer Nature, vydavateľ Nature, vyvíja svoje vlastné nástroje na detekciu textu a obrázkov, nazývané Geppetto a SnapShot, ktoré označujú nezrovnalosti, ktoré sú potom vyhodnocované ľuďmi. (Tím Nature news je redakčne nezávislý od svojho vydavateľa.)

Vydavateľské skupiny tiež podnikajú kroky, aby reagovali na obrázky vygenerované AI. Hovorca Medzinárodnej asociácie vedeckých, technických a medicínskych vydavateľov (STM) v Oxforde vo Veľkej Británii uviedol, že túto otázku berie „veľmi vážne“ a reaguje na iniciatívy ako napr. United2Act a STM Integrity Hub, ktorý rieši aktuálne problémy s povinným publikovaním a ďalšie problémy akademickej integrity.

Christopher, ktorý vedie pracovnú skupinu STM pre zmeny a duplikácie obrázkov, hovorí, že rastie povedomie o tom, že bude potrebné vyvinúť spôsoby overovania nespracovaných údajov – napríklad označovaním obrázkov zhotovených mikroskopom neviditeľnými vodoznakmi podobnými tým, ktoré sa používajú. Vodoznaky v textoch generovaných AI – to by mohla byť správna cesta. To si vyžaduje nové technológie a nové štandardy pre výrobcov zariadení, dodáva.

Patrick a ďalší sa obávajú, že vydavatelia nekonajú dostatočne rýchlo, aby sa vyhli hrozbe. „Obávame sa, že to bude len ďalšia generácia problémov v literatúre, s ktorými sa nezaoberajú, kým nie je neskoro,“ hovorí.

Niektorí sú však optimistickí, že obsah generovaný AI, ktorý sa dnes objavuje v článkoch, bude objavený v budúcnosti.

„Pevne verím, že technológia sa zlepší do tej miery, že rozpozná údaje, ktoré sa dnes vytvárajú – pretože v určitom bode sa to bude považovať za relatívne hrubé,“ hovorí Patrick. "Podvodníci by nemali v noci dobre spať. Mohli by oklamať súčasný proces, ale nemyslím si, že ho dokážu oklamať navždy."

-

Saguy, A. a kol. Malý pervitín. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto