Slike, ustvarjene z umetno inteligenco, ogrožajo znanost – tako jih želijo raziskovalci prepoznati

Raziskovalci se borijo proti lažnim slikam, ki jih ustvari umetna inteligenca, v znanstvenih publikacijah. Razvijajo se nove metode odkrivanja.

Slike, ustvarjene z umetno inteligenco, ogrožajo znanost – tako jih želijo raziskovalci prepoznati

Znanstveniki manipulirajo s številkami in množično proizvajajo ponarejene dokumente Obvezni založniki – problematični rokopisi so že dolgo nadloga v znanstveni literaturi. Znanstveni detektivi delajo neutrudno, da razkrijemo to napačno ravnanje in popravimo znanstveni zapis. Toda njihovo delo postaja vse težje, saj se je pojavilo novo, močno orodje za goljufe: generative umetna inteligenca (AI).

"Generativni AI se razvija zelo hitro," pravi Jana Krištof, analitik celovitosti slike pri FEBS Press v Heidelbergu, Nemčija. "Ljudje, ki delajo na mojem področju - celovitost slike in politika objavljanja - postajajo vse bolj zaskrbljeni zaradi možnosti, ki jih ponuja."

Lahkotnost, s katero besedila generativnih orodij AI, slik in podatkov vzbuja strah pred vedno bolj nezanesljivo znanstveno literaturo, preplavljeno s ponarejenimi številkami, rokopisi in sklepi, ki jih ljudje težko odkrijejo. Tekma v oboroževanju se že pojavlja, saj si strokovnjaki za integriteto, založniki in tehnološka podjetja marljivo prizadevajo Razvijte orodja AI, ki lahko pomaga hitro prepoznati zavajajoče elemente, ki jih ustvari umetna inteligenca, v specializiranih člankih.

"To je zastrašujoč razvoj," pravi Christopher. "Vendar so tudi pametni ljudje in predlagane so dobre strukturne spremembe."

Strokovnjaki za integriteto raziskav poročajo, da čeprav je besedilo, ustvarjeno z umetno inteligenco, v določenih okoliščinah že dovoljeno v številnih revijah, se lahko uporaba takih orodij za ustvarjanje slik ali drugih podatkov šteje za manj sprejemljivo. »V bližnji prihodnosti bomo morda v redu z besedilom, ki ga ustvari umetna inteligenca,« pravi Elisabeth Bik, specialist za slikovno forenziko in svetovalec v San Franciscu v Kaliforniji. "Vendar potegnem črto, ko gre za ustvarjanje podatkov."

Bik, Christopher in drugi menijo, da se podatki, vključno s slikami, ustvarjeni z generativno umetno inteligenco, že pogosto uporabljajo v literaturi in da obvezni založniki uporabljajo orodja umetne inteligence za izdelavo velikih rokopisov (glejte »Kviz: Ali lahko opazite ponaredke z umetno inteligenco?«).

Prepoznavanje slik, ki jih ustvari umetna inteligenca, predstavlja ogromen izziv: s prostim očesom jih je pogosto skoraj nemogoče ločiti od resničnih slik. »Počutimo se, kot da vsak dan naletimo na slike, ki jih ustvari umetna inteligenca,« pravi Christopher. "Ampak če tega ne dokažete, lahko storite zelo malo."

Obstaja nekaj jasnih primerov uporabe generativne umetne inteligence v znanstvenih slikah, kot je zdaj zloglasna podoba podgane z absurdno velikimi genitalijami in nesmiselne oznake, ustvarjene z orodjem Midjourney image. Grafika, ki jo je februarja objavila strokovna revija, je povzročila vihar na družbenih omrežjih in bila umaknjen nekaj dni kasneje.

Vendar večina primerov ni tako očitnih. Slike, ustvarjene s programom Adobe Photoshop ali podobnimi orodji pred pojavom generativne umetne inteligence - zlasti v molekularni in celični biologiji - pogosto vsebujejo osupljive značilnosti, ki jih lahko prepoznajo detektivi, kot so enaka ozadja ali nenavadno pomanjkanje prog ali lis. Liki, ustvarjeni z umetno inteligenco, pogosto ne kažejo takšnih lastnosti. "Vidim veliko dokumentov, zaradi katerih pomislim, da ti Western bloti niso videti resnični - vendar ni kajenja," pravi Bik. "Vse, kar lahko rečete, je, da samo izgledajo čudno, in seveda to ni dovolj dokazov, da bi stopili v stik z urednikom."

Vendar pa obstajajo znaki, da se v objavljenih rokopisih pojavljajo znaki, ki jih ustvari umetna inteligenca. Besedil, napisanih z orodji, kot je ChatGPT, je v člankih vse več, kar je razvidno iz tipičnih stavkov chatbotov, ki jih avtorji pozabijo odstraniti, in značilnih besed, ki jih običajno uporabljajo modeli AI. "Zato moramo domnevati, da se to zgodi tudi za podatke in slike," pravi Bik.

Drug znak, da goljufi uporabljajo sofisticirana orodja za slikanje, je, da se večina težav, ki jih raziskovalci trenutno odkrivajo, pojavlja v delih, ki so stara več let. "V zadnjih letih smo videli vse manj težav s slikami," pravi Bik. "Mislim, da je večina ljudi, ki so bili ujeti pri manipuliranju s slikami, začela ustvarjati čistejše slike."

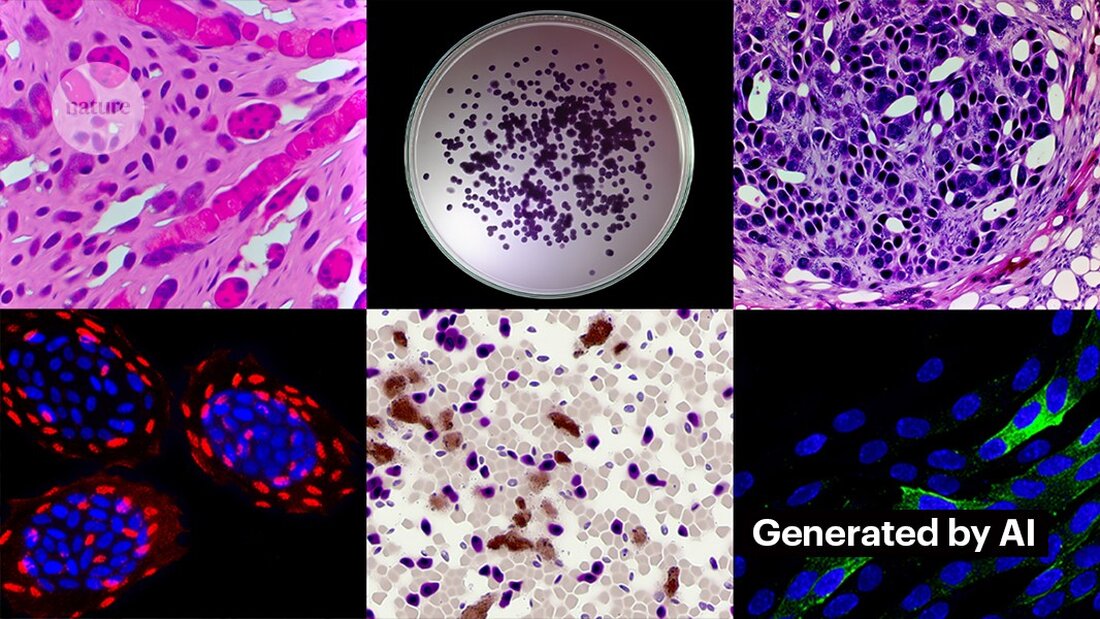

Ustvarjanje čistih slik z generativno umetno inteligenco ni težko. Kevin Patrick, detektiv znanstvenih slik, znan kot Cheshire na družbenih omrežjih, je pokazal, kako enostavno je lahko, in svoje ugotovitve objavil na X. Z uporabo Photoshopovega orodja AI Generative Fill je Patrick ustvaril realistične slike tumorjev, celičnih kultur, Western blotov in še več, kar bi se lahko pojavilo v znanstvenih člankih. Ustvarjanje večine slik je trajalo manj kot minuto (glejte »Ustvarjanje lažne znanosti«).

»Če lahko to storim jaz, potem bodo zagotovo to storili tudi tisti, ki so plačani za ustvarjanje lažnih podatkov,« pravi Patrick. "Verjetno obstaja veliko drugih podatkov, ki bi jih lahko ustvarili s takšnimi orodji."

Nekateri založniki poročajo, da so v objavljenih študijah našli dokaze o vsebini, ki jo je ustvarila umetna inteligenca. To vključuje PLoS, ki je bil opozorjen na sumljivo vsebino in je z internimi preiskavami našel dokaze o besedilu in podatkih, ustvarjenih z umetno inteligenco, v člankih in prispevkih, pravi Renée Hoch, urednica skupine za etiko publikacij PLoS v San Franciscu v Kaliforniji. (Hoch ugotavlja, da uporaba umetne inteligence ni prepovedana v revijah PLoS in da politika umetne inteligence temelji na avtorski odgovornosti in preglednih razkritjih.)

Druga orodja bi lahko ponudila tudi priložnosti za ljudi, ki želijo ustvariti lažno vsebino. Prejšnji mesec so raziskovalci objavili 1 generativni model AI za ustvarjanje mikroskopskih slik visoke ločljivosti – in nekateri strokovnjaki za celovitost so izrazili pomisleke glede tega dela. »To tehnologijo lahko zlahka uporabijo ljudje s slabimi nameni za hitro ustvarjanje na stotine ali tisoče lažnih slik,« pravi Bik.

Yoav Shechtman iz tehnološkega inštituta Technion–Israel v Haifi, ustvarjalec orodja, pravi, da je orodje uporabno za ustvarjanje podatkov za usposabljanje za modele, ker je mikroskopske slike visoke ločljivosti težko dobiti. Vendar dodaja, da ni uporaben za ustvarjanje ponaredkov, ker imajo uporabniki malo nadzora nad rezultati. Obstoječa programska oprema za urejanje slik, kot je Photoshop, je bolj uporabna za manipulacijo številk, predlaga.

Čeprav človeške oči tega morda ne zmorejo Prepoznajte slike, ustvarjene z AI, bi to lahko naredila umetna inteligenca (glejte »Slike umetne inteligence je težko prepoznati«).

Razvijalci orodij, kot sta Imagetwin in Proofig, ki uporabljajo AI za odkrivanje težav s celovitostjo znanstvenih slik, širijo svojo programsko opremo za filtriranje slik, ustvarjenih z generativno AI. Ker je takšne slike tako težko prepoznati, obe podjetji ustvarjata lastni bazi podatkov generativnih slik umetne inteligence za usposabljanje svojih algoritmov.

Proofig je v svojem orodju že izdal funkcijo za prepoznavanje mikroskopskih slik, ustvarjenih z umetno inteligenco. Soustanovitelj Dror Kolodkin-Gal v Rehovotu v Izraelu pravi, da je algoritem pri testiranju s tisoči resničnih slik iz člankov, ustvarjenih z umetno inteligenco, v 98 % primerov pravilno prepoznal slike umetne inteligence in imel lažno pozitivno stopnjo 0,02 %. Dror dodaja, da ekipa zdaj poskuša razumeti, kaj točno zazna njihov algoritem.

»Veliko upam od teh orodij,« pravi Christopher. Opozarja pa, da morajo njihove rezultate vedno ovrednotiti strokovnjaki, ki lahko preverijo težave, na katere kažejo. Christopher še ni videl nobenega dokaza, da je programska oprema za prepoznavanje slik z umetno inteligenco zanesljiva (notranja ocena Proofiga še ni bila objavljena). Ta orodja so »omejena, a vsekakor zelo uporabna, ker nam omogočajo, da povečamo prizadevanja za pregled prispevkov,« dodaja.

Mnogi založniki in raziskovalne ustanove ga že uporabljajo Dokaz in Imagetwin. Znanstvene revije na primer uporabljajo Proofig za preverjanje težav s celovitostjo slik. Po besedah Meagan Phelan, direktorice komunikacij za Science v Washingtonu DC, orodje še ni odkrilo nobenih slik, ustvarjenih z umetno inteligenco.

Springer Nature, založnik Nature, razvija lastna orodja za zaznavanje besedila in slik, imenovana Geppetto in SnapShot, ki označujeta nepravilnosti, ki jih nato ocenijo ljudje. (Ekipa novic Nature je uredniško neodvisna od založnika.)

Založniške skupine se prav tako odzivajo na slike, ustvarjene z umetno inteligenco. Tiskovni predstavnik Mednarodnega združenja znanstvenih, tehničnih in medicinskih založnikov (STM) v Oxfordu v Veliki Britaniji je dejal, da to vprašanje jemlje "zelo resno" in se odziva na pobude, kot je npr. United2Act in STM Integrity Hub, ki obravnava aktualna vprašanja obveznega objavljanja in druga vprašanja akademske integritete.

Christopher, ki vodi delovno skupino STM za spreminjanje in podvajanje slik, pravi, da se vedno bolj zavedamo, da bo treba razviti načine za preverjanje neobdelanih podatkov – na primer z označevanjem slik, posnetih z mikroskopi, z nevidnimi vodnimi žigi, podobnimi tistim, ki se uporabljajo. Vodni žigi v besedilih, ustvarjenih z umetno inteligenco – to bi lahko bila prava pot. To zahteva nove tehnologije in nove standarde za proizvajalce naprav, dodaja.

Patricka in druge skrbi, da založniki ne ukrepajo dovolj hitro, da bi odpravili grožnjo. »Bojimo se, da bo to le še ena generacija problemov v literaturi, ki jih ne obravnavajo, dokler ne bo prepozno,« pravi.

Kljub temu so nekateri optimistični, da bodo vsebine, ustvarjene z umetno inteligenco, ki se danes pojavljajo v člankih, odkrili v prihodnosti.

»Prepričan sem, da se bo tehnologija izboljšala do te mere, da bo prepoznala podatke, ki se ustvarjajo danes – ker bodo na neki točki veljali za razmeroma grobe,« pravi Patrick. "Goljufi ne bi smeli dobro spati ponoči. Lahko bi preslepili trenutni postopek, vendar mislim, da ne morejo zavajati procesa za vedno."

-

Saguy, A. et al. Majhen met. https://doi.org/10.1002/smtd.202400672 (2024).

Suche

Suche

Mein Konto

Mein Konto